Embora a turbulência seja um fenômeno que se caracteriza pela movimentação caótica das partículas de um fluido, existem técnicas capazes de identificar estruturas coerentes, permitindo a previsão desses movimentos.

© Astrophysical Journal Letters (fluxos turbulentos)

Estudos sobre a dispersão de cinzas vulcânicas, ciclones, tornados, tsunamis, ciclos solares, formação de planetas e estrelas, o Universo primordial e outras áreas tão diversas como o transporte de sangue em sistema cardiovascular e a fusão termonuclear controlada poderão se beneficiar destas pesquisas.

Os trabalhos foram liderados pelo físico espacial Abraham Chian, do Instituto Nacional de Pesquisas Espaciais (Inpe), e pelo matemático computacional Erico Rempel, do Instituto Tecnológico de Aeronáutica (ITA), em São José dos Campos (SP), em cooperação com um colega da Universidade de Estocolmo (Suécia) e um aluno de doutorado do Inpe.

Um dos estudos foi concluído durante a visita de Chian ao Instituto de Tecnologia da Califórnia, nos Estados Unidos, com apoio de uma bolsa da Fundação Guggenheim. O estudo contou com a participação de Pablo Muñoz, estudante de doutorado do Inpe, que recebeu prêmio de melhor trabalho de alunos durante o 9º Congresso Latino-Americano de Geofísica Espacial realizado na Costa Rica, em abril de 2011.

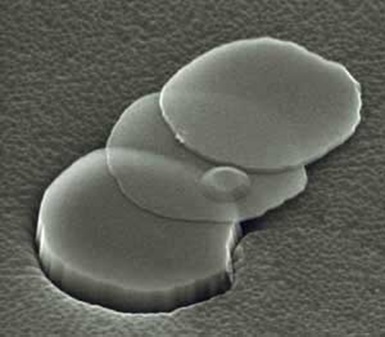

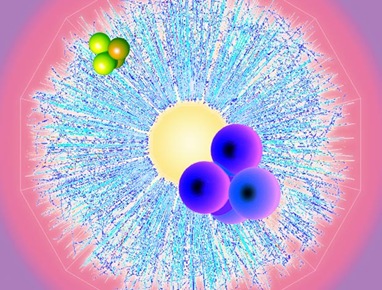

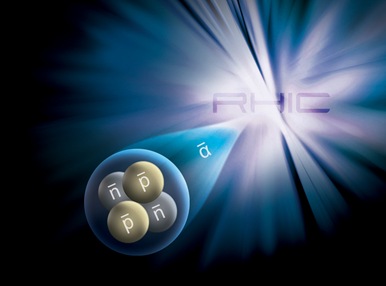

Os cientistas estudaram o campo magnético relacionado às estruturas coerentes da turbulência verificada no plasma solar. De acordo com Chian, utilizando os dados fornecidos pelos instrumentos a bordo de quatro sondas espaciais da missão Cluster, o grupo detectou em frente a uma nuvem magnética interplanetária duas estruturas coerentes na forma denominada como “lâminas de corrente”.

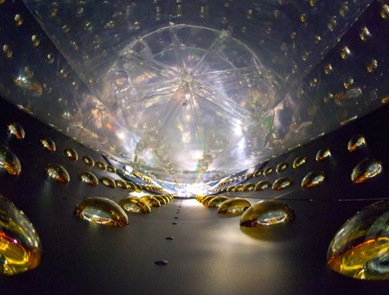

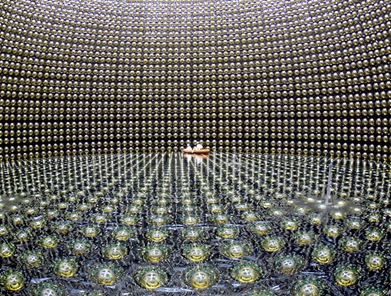

“A análise de dados de flutuações magnéticas na vizinhança dessas estruturas coerentes demonstrou que o vento solar exibe o comportamento de turbulência bem desenvolvida do tipo Kolmogorov, semelhante às turbulências encontradas na borda de uma máquina de plasma de fusão termonuclear, na atmosfera solar, no meio interestelar, em um túnel de vento e na copa da floresta amazônica, para citar alguns exemplos”, disse Chian à Agência FAPESP.

A caracterização da dinâmica da borda dianteira de uma nuvem magnética interplanetária é fundamental para o monitoramento e a previsão de clima espacial, uma vez que existe a evidência de que a tempestade magnética na Terra pode ser iniciada pela chegada de uma nuvem magnética proveniente de uma erupção solar.

“Os eventos extremos na natureza, tais como ciclones, tsunamis, a precipitação excessiva de chuvas em regiões localizadas, manchas solares e ejeções de massas coronais interplanetárias, estão relacionados às estruturas coerentes que dominam a dinâmica da turbulência e podem causar grandes impactos no clima terrestre, clima espacial e ambiente solar-terrestre”, explicou.

O segundo trabalho foi iniciado durante o estágio de pós-doutorado de Rempel na Universidade de Cambridge, com bolsa da FAPESP, e contou com a colaboração de Chian e de Axel Brandenburg, professor do Instituto Nórdico de Astrofísica Teórica e da Universidade de Estocolmo (Suécia).

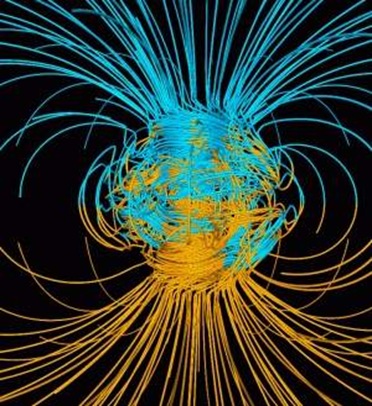

De acordo com Chian, Brandenburg é um dos pioneiros do modelo de dínamo cósmico. “Esse modelo de dínamo pode explicar a origem e a evolução de ciclos solares, por exemplo, o aparecimento de períodos prolongados de atividades calmas do Sol conhecidos como os Grandes Mínimos”, disse.

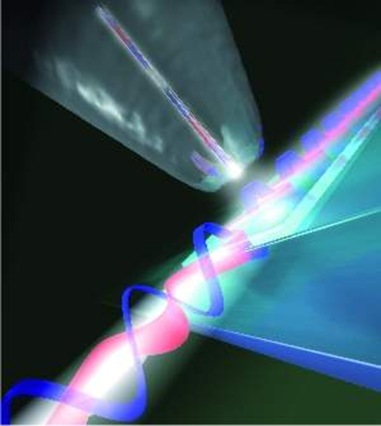

No estudo, o grupo investigou as estruturas coerentes lagrangianas da turbulência astrofísica, com base na simulação numérica de um modelo não-linear de dínamo.

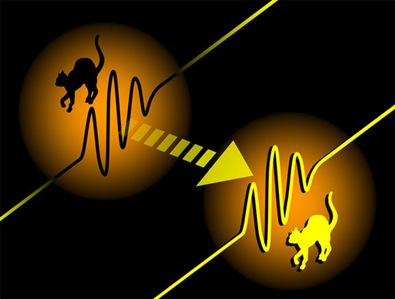

As estruturas coerentes lagrangianas são linhas ou superfícies materiais que atuam como barreiras de transporte na turbulência. Inspirado pela teoria de caos, esse conceito foi introduzido há quase dez anos por George Haller, atualmente professor de engenharia mecânica da Universidade de McGill, no Canadá.

“Essa nova técnica não-linear permite uma visualização mais acurada da dinâmica e estrutura complexa de fluidos, que não seria possível usando as técnicas tradicionais baseadas em formalismo euleriano”, disse Chian.

Essas estruturas são determinadas por meio da computação do máximo expoente de Lyapunov de tempo finito, que fornece o valor médio da taxa máxima de divergência ou do alongamento entre as trajetórias das partículas num certo intervalo de tempo.

“Isso permite a identificação de trajetórias atrativas e repulsivas em imagens obtidas das simulações numéricas ou imagens reais do campo de velocidade de um fluido, revelando o esqueleto da turbulência que forma as barreiras para o transporte das partículas. Os cruzamentos entre essas barreiras são responsáveis pela mistura caótica de partículas”, disse.

O estudo de estruturas coerentes lagrangianas, segundo os autores, tem aplicações em diversas áreas, por exemplo, a previsão do movimento dos poluentes na atmosfera e no mar, a migração dos fitoplânctons no oceano, o fluxo aperiódico em furacões, a interação entre o fluido e a estrutura no entorno das válvulas cardíacas e o plasma termonuclear em máquinas de confinamento magnético.

De acordo com Rempel, o grupo brasileiro foi o primeiro a introduzir essa nova técnica para a astrofísica. Usando as imagens da turbulência de plasma simuladas para modelar a geração do campo magnético nas camadas convectivas do Sol e de outras estrelas, foi comprovado pelo estudo que as estruturas coerentes lagrangianas são capazes de distinguir nitidamente os detalhes da complexidade da distribuição espacial de barreiras de transporte entre dois regimes diferentes do dínamo.

“Desde que o conceito foi desenvolvido por Haller, a técnica foi aplicada para problemas de fluidos, tanto em simulações como em dados observacionais voltados para dispersão de poluentes nos oceanos, por exemplo, mas não tinham ainda sido utilizadas, no campo da astrofísica, em fluidos com campo magnético”, disse Rempel.

Essas estruturas coerentes marcam certas direções preferenciais das partículas de fluidos em movimento. Quando um poluente é arrastado pelos vórtices e correntes do oceano a identificação das estruturas coerentes permite detectar linhas de atração que possibilitam prever para onde o fluido irá se movimentar. O mesmo fenômeno pode acontecer, por exemplo, com as cinzas expelidas na atmosfera por um vulcão.

“No enfoque da astrofísica, nosso objetivo era saber qual o impacto do campo magnético sobre os movimentos turbulentos do plasma de uma estrela”, disse Rempel, que coordenou o projeto Simulação numérica e análise de transição para turbulência em plasmas espaciais: uma abordagem baseada em sistemas dinâmicos, apoiado pela FAPESP.

Segundo ele, na camada convectiva do Sol, uma região intensamente turbulenta, as partículas se movimentam como se estivessem aprisionadas em vórtices. As estuturas coerentes lagrangianas marcam as fronteiras desses vórtices, delimitando as regiões do fluido entre as quais as partículas não se misturam.

“Quando fazemos o estudo das estruturas coerentes, vemos que algumas partículas podem se cruzar, passando para outras regiões do fluido. No caso da estrela, observamos que, quando o campo magnético ficava mais forte, existiam menos cruzamentos – isto é, a turbulência diminuía”, disse.

Esses resultados, segundo Rempel, foram obtidos a partir de uma simulação ainda bastante simplificada. “A partir desse modelo acadêmico, vamos agora procurar estender essa aplicação a modelos mais realistas da camada convectiva do Sol”, disse.

Fonte: Agência FAPESP e Astrophysical Journal Letters