O zero absoluto é um limite inviolável para além do qual é impossível explorar. De fato, há um reino estranho de temperaturas negativas, que não só existe na teoria, mas também se mostrou acessível na prática, e poderia revelar novos estados da matéria.

© NewScientist (temperaturas absolutas negativas)

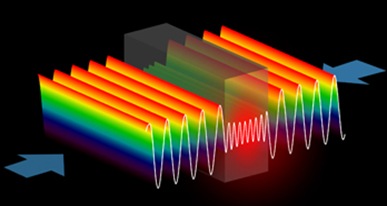

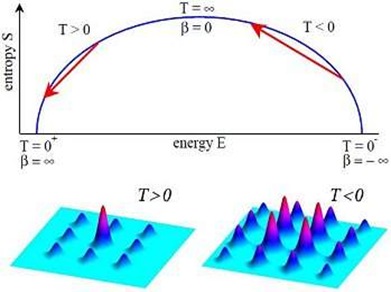

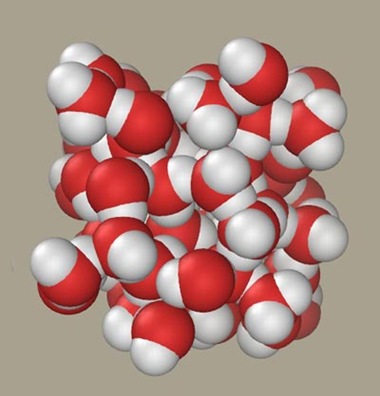

A temperatura é definida pela forma como a adição ou a remoção de energia afeta a quantidade de desordem, ou entropia, em um sistema.

Para os sistemas nas temperaturas positivas com as quais estamos acostumados, o acréscimo de energia aumenta a desordem: aquecer um cristal de gelo vai fazer com que ele se derreta em um líquido mais desordenado, por exemplo.

Continue a remover energia e você vai chegar cada vez mais perto do zero na escala absoluta, ou escala Kelvin, que é -273,15 °C, onde a energia do sistema e a entropia estarão no mínimo.

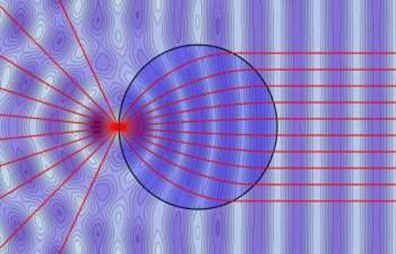

Sistemas de temperatura negativa, entendidas como abaixo do zero absoluto, têm comportamento oposto: acrescentar energia reduz sua desordem e, portanto, sua temperatura.

Mas eles não são frios no sentido convencional de que o calor irá fluir para eles a partir de sistemas com temperaturas positivas.

Na verdade, os sistemas com temperaturas absolutas negativas têm mais átomos em estados de alta energia do que é possível mesmo nas mais elevadas temperaturas na escala das "absolutas positivas".

Assim, o calor deve sempre fluir deles para os sistemas acima de zero Kelvin.

Criar sistemas de temperatura negativa para estudar as propriedades desse mundo bizarro, contudo, pode ser complicado.

Não dá para criá-los de maneira suave e contínua, sempre baixando a temperatura, já que não será possível romper a barreira do zero absoluto da maneira usual.

Mas é possível saltar sobre essa barreira, passando diretamente de uma determinada temperatura absoluta positiva (acima do zero absoluto) para uma temperatura absoluta negativa (abaixo do zero absoluto).

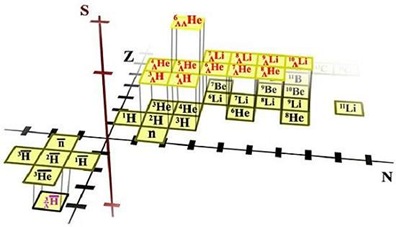

Isso já foi feito em experimentos nos quais núcleos atômicos foram colocados em um campo magnético, sob o qual eles agem como minúsculos ímãs, alinhando-se com o campo.

Quando o campo é subitamente revertido, os núcleos ficam momentaneamente alinhados na direção oposta àquela que corresponde ao seu menor estado de energia.

Na fração de tempo em que permanecem nesse estado fugaz, eles se comportam de forma coerente com a de um sistema com temperaturas absolutas negativas. Logo após eles se viram e se realinham com o campo.

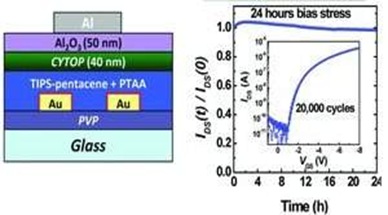

© Physical Review Letters (entropia em função da energia)

Como os núcleos só podem alternar entre dois estados possíveis, paralelo ao campo ou oposto a ele, este sistema oferece poucas possibilidades para investigação.

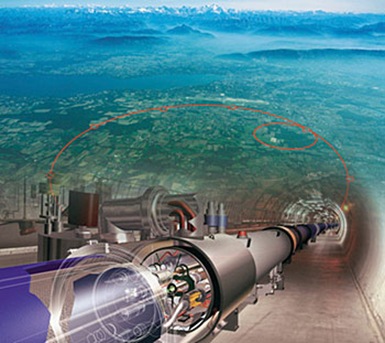

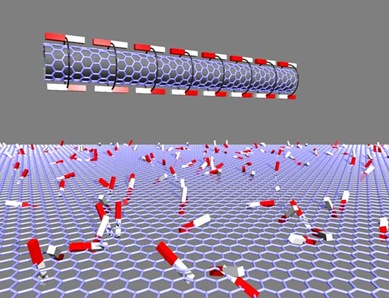

Em 2005, Allard Mosk, atualmente na Universidade de Twente, na Holanda, idealizou um experimento que poderia oferecer mais possibilidades de estudos do regime de temperaturas negativas.

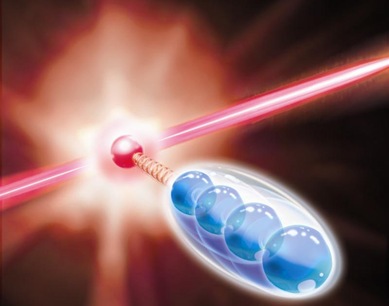

Primeiro, lasers são usados para agrupar os átomos até formar uma bola muito coesa, que estaria em um estado altamente ordenado, ou de baixa entropia.

Outros lasers são então disparados sobre a bola de átomos para criar uma matriz de luz, a chamada grade óptica, que circundaria a bola de átomos com uma série de "poços" de baixa energia. O primeiro conjunto de lasers é então reajustado de modo que eles passam a tentar desconstruir a bola de átomos. Isso deixa os átomos em um estado instável, como se estivessem equilibrados no pico de uma montanha, prestes a rolar ladeira abaixo. A grade óptica funciona como uma série de fendas ao longo da montanha, travando a "descida" dos átomos montanha abaixo.

Neste estado, remover parte da energia potencial dos átomos, levando-os a rolar e se distanciar uns dos outros, levaria a uma maior desordem, a exata definição de um sistema de temperaturas absolutas negativas.

Agora a ideia de Mosk foi refinada por Achim Rosch e seus colegas da Universidade de Colônia, na Alemanha.

A nova proposta de experimento é essencialmente a mesma, mas os cálculos de Rosch e sua equipe dão mais fundamento à ideia, sustentando que ela é realmente factível.

O grande avanço, contudo, é que eles sugerem uma maneira de testar se o experimento realmente produzirá temperaturas negativas absolutas.

Como os átomos no estado de temperaturas negativas têm energias relativamente altas, eles deverão se mover mais rapidamente quando liberados da armadilha do que ocorrerá com uma nuvem de átomos com temperatura positiva.

Este é um território desconhecido, nunca antes explorado, com grande potencial para revelar surpresas.

Fonte: NewScientist e Physical Review Letters