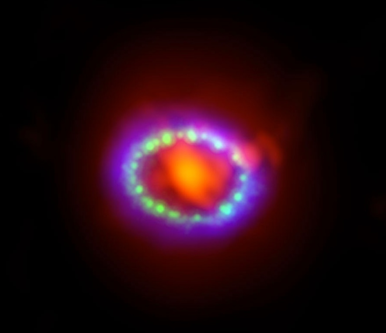

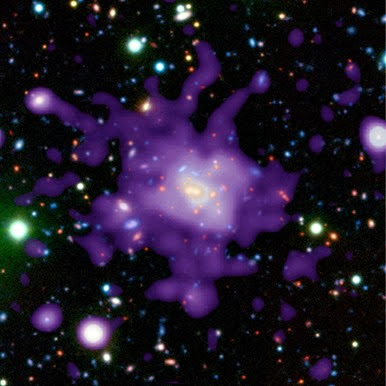

Um dos famosos exemplos da estranheza da mecânica quântica é o paradoxo do gato de Schrödinger.

© Revista Física (o gato de Schrödinger)

O gato de Schrödinger é um experimento mental, em que um gato é posto em uma caixa onde um frasco de veneno pode ser aberto pelo estado de uma partícula quântica. Se você colocar um gato dentro de uma caixa opaca e fazer a sua vida dependente de um evento aleatório, quando é que o gato morrerá? Quando eventos ocorrerem ao acaso, ou quando você abrir a caixa?

Embora o senso comum sugere que na mecânica quântica a interpretação de "Copenhagen" enunciada pelo físico dinamarquês Niels Bohr em 1920, diz que é o último. Alguém tem que observar o resultado antes que se torne definitiva. Até então, paradoxalmente, o gato está vivo e morto ao mesmo tempo.

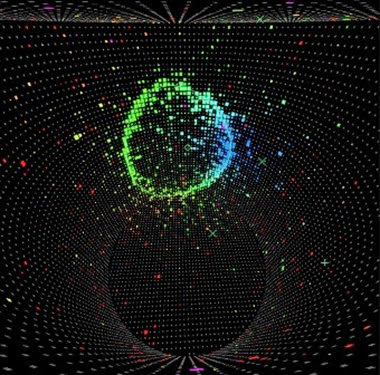

Uma equipe de físicos das universidades de Rochester, Berkeley e Washington, pela primeira vez mostrou que, de fato, é possível acompanhar através de todo o processo, se o gato vive ou morre no final.

O paradoxo do gato de Schrödinger é uma questão crítica em computadores quânticos, onde a entrada é um emaranhado de estados, como a vida e morta embaralhada do gato, ainda a resposta para saber se o animal está vivo ou morto tem de ser definida.

"Para Bohr e outros, o processo foi instantâneo, quando você abriu a caixa, o sistema entrou em colapso emaranhado em um estado clássico definido. Este postulado agitado debate na mecânica quântica", disse Irfan Siddiqi, professor associado de física da Universidade da Califórnia, em Berkeley. "Mas o rastreamento em tempo real de um sistema quântico mostra que é um processo contínuo, e que podemos extrair constantemente informações do sistema, uma vez que vai do quântico ao clássico. Este nível de detalhe nunca foi considerado acessível pelos fundadores da teoria quântica".

Para os computadores quânticos, isso permitiria que a correção de erro fosse contínua. O mundo real, onde a luz e o calor hà vibração, um sistema quântico pode sair de seu estado quântico para um mundo real, o chamado estado clássico, como abrir a caixa para olhar o gato e forçando-o a estar morto ou vivo. A grande questão sobre os computadores quânticos é se é possível extrair informações sem destruir o sistema quântico inteiramente.

É possível sondar continuamente um sistema muito suavemente para obter um pouco de informação e continuamente corrigí-lo, empurrando-o de volta na trajetória, em direção ao objetivo final.

No mundo da física quântica, um sistema pode estar em dois estados superpostos ao mesmo tempo, desde que ninguém esteja observando. Uma observação perturba o sistema e obriga-o estar em um dos dois estados. As funções de onda emaranhadas originais colapsam em um estado clássico.

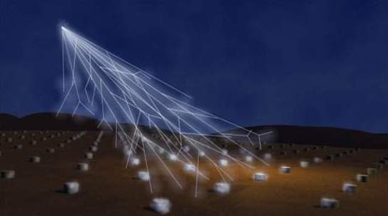

Nos últimos 10 anos, teóricos como Andrew N. Jordan, professor de física na Universidade de Rochester, desenvolveram teorias que predizem a forma mais provável em que um sistema quântico entrará em colapso.

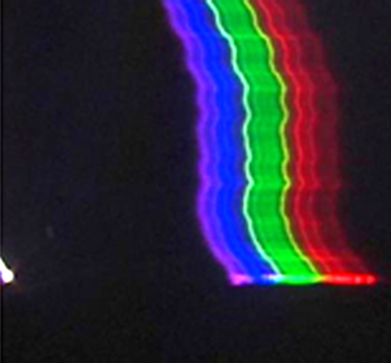

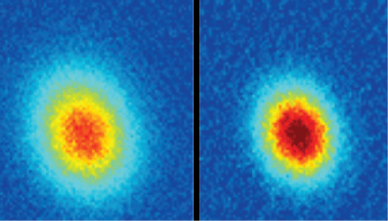

© Irfan Siddiqi (trajetória quântica)

"A equipe de Rochester desenvolveu novos cálculos para prever o caminho mais provável, com alta precisão, da mesma forma pode-se usar equações de Newtown para prever o caminho menos complicado de uma bola rolando montanha abaixo", disse Siddiqi. "As implicações são significativas, como agora nós podemos projetar sequências de controle para dirigir um sistema ao longo de uma determinada trajetória. Por exemplo, em química pode-se usar isso para preferir certos produtos de uma reação sobre os outros."

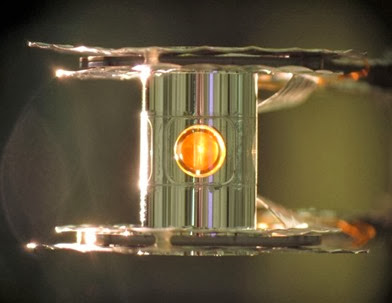

O pesquisador Steve Weber, um estudante de graduação no grupo de Siddiqi, e ex-companheiro de pós-doutorado da Siddiqi Kater Murch, agora um professor assistente de física na Universidade de Washington em St. Louis, provou que Jordan tem razão. Eles mediram a trajetória da função de onda de um circuito quântico - um qubit, análogo ao bit em um computador normal - como ele mudou. O circuito, de um pêndulo supercondutor chamado de transmon, poderia estar em dois estados de energia diferentes e foi acoplado a um segundo circuito para obter a tensão final, correspondente à frequência da oscilação.

Se uma reação química for sondada em detalhes, por exemplo, será possível encontrar o caminho mais provável que a reação levaria e projetar uma forma de orientar a reação aos produtos que você quer.

"A experiência demonstra que, para qualquer escolha do estado quântico final, o mais provável ou 'caminho ideal' de conectá-los em um determinado momento pode ser encontrada e prevista", disse Jordan. "Isso confirma a teoria e abre caminho para técnicas de controle quântica ativas."

Fonte: Nature