Um avanço demonstrado por pesquisadores da IBM e do Instituto Politécnico Federal de Lausanne, na Suíça, através dos fenômenos quânticos será possível diminuir o consumo de energia dos equipamentos eletrônicos por um fator de 100.

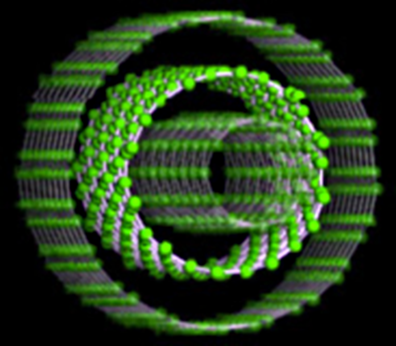

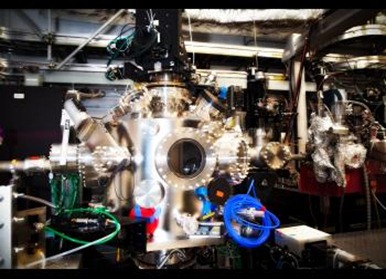

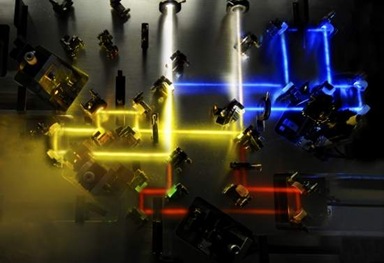

© IBM (ilustração de um transístor quântico com nanotubos)

Como o grande limitador ao aumento de velocidade dos processadores é justamente o elevado consumo de energia, econsequentemente o calor dissipado por eles, é de se esperar um aumento equivalente na velocidade de processamento.

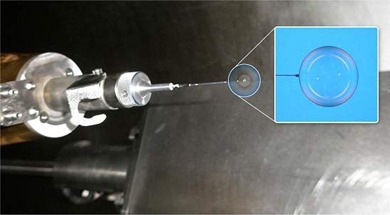

Recentemente, a IBM anunciou uma tecnologia que usa metal líquido para retirar calor dos processadores, afirmando que isso permitiria colocar um supercomputador atual dentro de um celular em breve.

O segredo está em um novo tipo de transístor, o elemento fundamental de toda a eletrônica, chamado Túnel-FET, ou TFET.

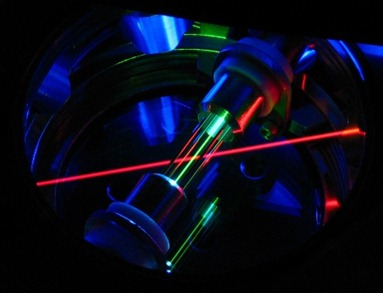

O termo túnel se refere ao fenômeno do tunelamento quântico, pelo qual uma partícula consegue atravessar uma barreira física - este fenômeno já é largamente utilizado, por exemplo, nos microscópios eletrônicos de tunelamento.

A tecnologia atual é baseada nos transistores de efeito de campo (FET, da sigla em inglês), onde um fluxo de elétrons ativa ou desativa o transístor - um fluxo de bilhões de elétrons, que esquenta tudo por onde passam.

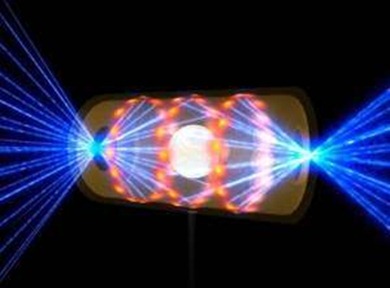

No transístor, duas câmaras são separadas por uma barreira de energia. Na primeira, uma multidão de elétrons fica esperando quando o transístor está desligado. Quando é aplicada uma tensão, eles cruzam a barreira de energia, ativando o transístor. É o que se chama de injeção termal.

Ocorre que alguns elétrons acabam cruzando essa barreira antes da hora, mesmo que aparentemente não tivessem energia para tanto. Esse é o efeito túnel, que sempre atrapalhou o funcionamento dos transistores.

Estreitando a barreira do transístor torna-se possível amplificar o efeito quântico e passar a basear o funcionamento do transístor inteiro nesse tunelamento, que é a chamada injeção por tunelamento. A energia necessária para que os elétrons cruzem a barreira é reduzida drasticamente.

"Substituindo o princípio do transístor de efeito de campo tradicional pelo efeito túnel, pode-se reduzir a tensão dos transistores de 1 volt para 0,2 volt," afirmou o Dr. Adrian M. Ionescu, que está desenvolvendo o Túnel-FET juntamente com Heike Riel.

Sua adoção é viável, uma vez que os processadores poderão ser construídos com FETs e Túnel-FETs convivendo no mesmo chip.

"Os protótipos atuais foram construídos em ambiente pré-industrial. Nós podemos razoavelmente esperar vê-los em produção em massa por volta de 2017," disse Ionescu.

Fonte: Nature