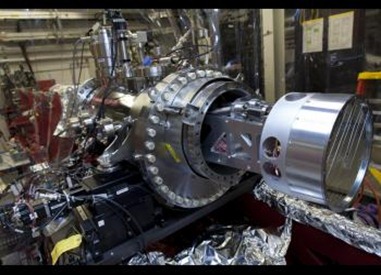

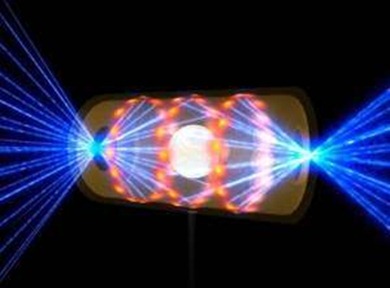

Usando 60 raios lasers de alta potência, combinados para atingir uma cápsula minúscula, físicos produziram um plasma com condições de densidade de energia extremas.

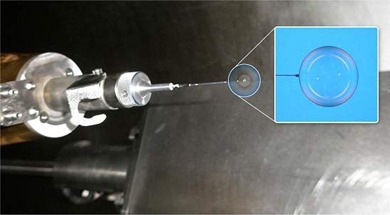

© LLNL (Omega Laser)

Essas condições incluem uma pressão de 100 bilhões de atmosferas, uma temperatura de 200 milhões Kelvin e uma densidade 20 vezes maior que a do ouro.

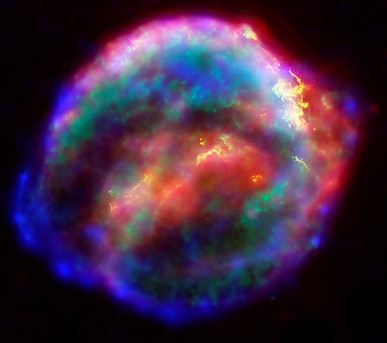

Antes desse super disparo de laser, essas condições só podiam ser encontradas no núcleo de planetas gigantes, como Júpiter e Saturno, ou no interior das estrelas.

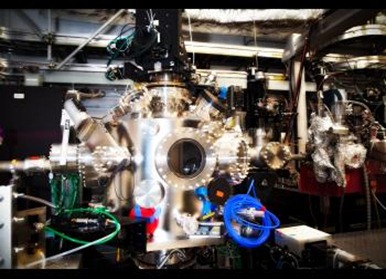

O experimento é um dos caminhos rumo à construção de uma "estrela artificial" controlada, onde a fusão nuclear poderá ser explorada para a geração sustentável de energia.

Muitos físicos acreditam que a fusão nuclear a laser seja a melhor saída para essa fonte de energia limpa.

O laboratório Omega Laser Facility, localizado na Universidade de Rochester, nos Estados Unidos, onde o recorde acaba de ser batido, é um dos que trabalham nesse sentido.

Os pesquisadores normalmente usam aceleradores para estudar as reações nucleares.

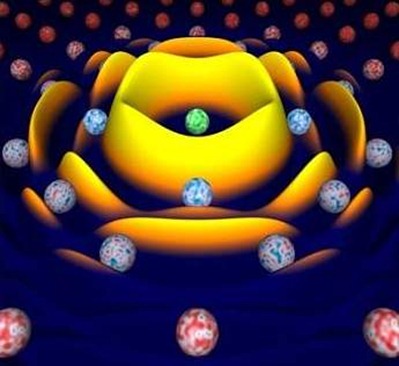

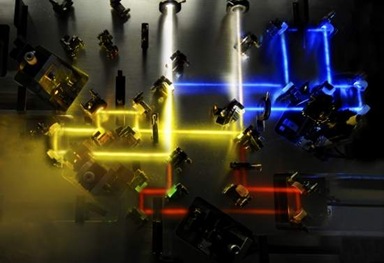

Neste laboratório, a equipe usou uma abordagem diferente, criando um plasma quente e denso, no qual elétrons são arrancados dos átomos para criar um plasma, o quarto estado da matéria.

O estado de plasma está presente nas estrelas, nos relâmpagos e até nas lâmpadas fluorescentes, na verdade 99% do Universo visível é composto de plasma.

Para obter esse plasma, todos os 60 feixes de laser do Laboratório Ômega foram dirigidos simultaneamente para a superfície de uma cápsula de vidro de um milímetro de diâmetro, cheia de isótopos pesados de hidrogênio - deutério e trítio.

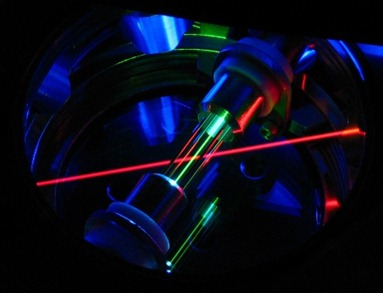

© LLNL (laser sobre uma esfera de vidro com deutério e trítio)

Os feixes de laser geram um plasma em rápida expansão, de alta temperatura, na superfície da cápsula, fazendo-a implodir.

Esta implosão, por sua vez, cria um plasma extremamente quente (100 milhões Kelvin) de íons de deutério e trítio, e de elétrons, dentro da cápsula.

Uma pequena fração dos íons de deutério e trítio se fundem, um processo que gera um nêutron viajando a um sexto da velocidade da luz, com cerca de 14,1 milhões de elétron-volts de energia - em comparação, a combustão de uma substância química comum, como a madeira ou o carvão, gera cerca de 1 elétron-volt de energia.

Conforme esses nêutrons energizados escapam da cápsula que está implodindo, uma pequena fração colide com os íons de deutério e trítio.

A partir dessas colisões, bastante raras, e da correspondente transferência de energia dos nêutrons para os íons, os pesquisadores podem obter uma medição precisa do processo de fusão nuclear.

Fonte: Physical Review Letters