O laser é uma invenção de mais de 50 anos de idade usado em diversas tecnologias. Recentemente, foi construído o antilaser, o primeiro aparelho capaz de prender e anular feixes de laser.

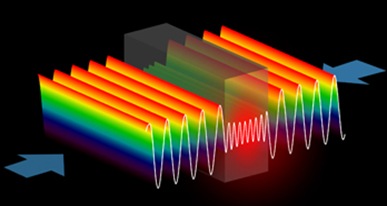

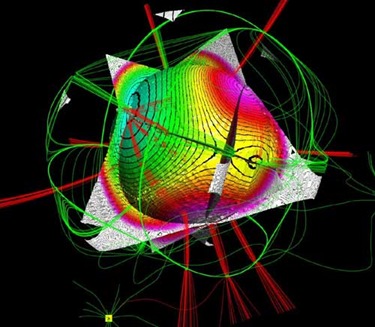

© Universidade de Yale (ondas de luz no antilaser)

Um antilaser consome a luz que o atinge, produzindo escuridão e calor. Sua aplicação poderá ocorrer provavelmente na próxima geração de computadores ópticos, que serão alimentados por luz e elétrons.

Um laser amplifica a luz e funciona como "meio de ganho", criando um feixe de fótons idênticos, uma onda de luz coerente, na qual todos os fótons têm a mesma frequência e amplitude e todos estão em fase.

A luz original é injetada em uma cavidade contendo um gás, situada entre dois espelhos. Os fótons alteram o estado quântico dos elétrons do gás, liberando outros fótons idênticos.

Com todos esses fótons refletindo-se de um lado para o outro entre os dois espelhos, e chocando-se com mais elétrons, cada vez mais fótons são liberados, todos idênticos, até criar um feixe brilhante de luz que escapa da armadilha.

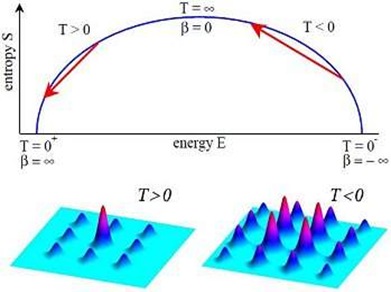

É assim que as coisas funcionam quando a seta do tempo aponta para o futuro, como usual.

O que A. Douglas Stone e seus colegas da Universidade de Yale fizeram agora foi colocar o relógio para funcionar ao reverso, pegando a luz de um laser e convertendo-a em calor.

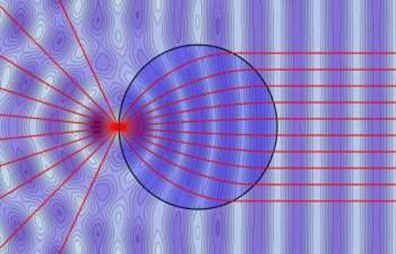

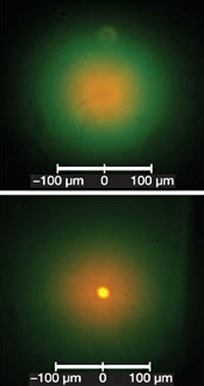

Como inverter todo o processo seria complicado demais, os pesquisadores tiveram a ideia de disparar dois feixes de laser, um na direção do outro, de forma que os dois se cancelassem perfeitamente.

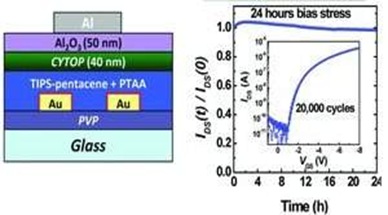

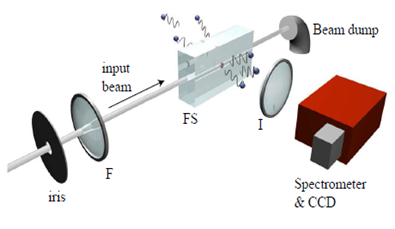

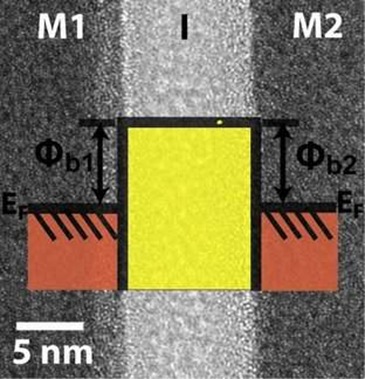

Os dois feixes de laser foram dirigidos para uma "cavidade" que é na verdade uma pastilha de silício, que funciona como "meio de perda".

O silício alinha as ondas de luz de tal forma que elas ficam presas, refletindo-se entre suas paredes indefinidamente, até serem absorvidas e se transformarem em calor.

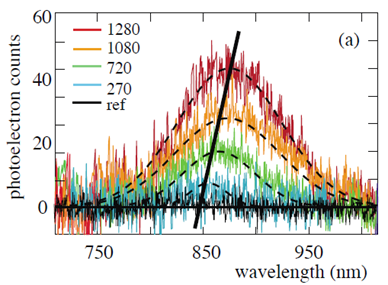

O antilaser de laser é chamado de tempo reverso ou CPA (Coherent Perfect Absorber). Não exatamente perfeito. O laser reverso de silício absorveu 99,4% da luz infravermelha do laser original, emitida em um comprimento de onda de 998,5 nanômetros, transformando-a em calor. Mas a teoria diz é possível chegar em 99,999% de absorção.

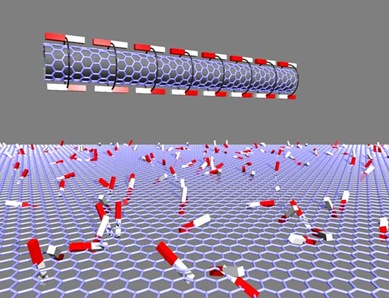

O protótipo do antilaser também ainda não tem o tamanho ideal. Ele mede 1 centímetro de lado, embora os cálculos indiquem que o ideal seria uma pastilha de 6 micrômetros.

A equipe também espera conseguir ajustar o dispositivo para que ele seja capaz de absorver lasers que emitem luz na faixa visível do espectro, assim como nas faixas específicas do infravermelho utilizadas em comunicações por fibra óptica.

Segundo os cientistas, ele poderá ser usado, no futuro, em chaves ópticas, sensores e até em uma próxima geração de computadores, os chamados computadores ópticos.

Como os dados nos processadores ópticos serão transferidos por luz, poderá ser necessário recolher o dado óptico e enviá-lo para um processamento externo, fora do chip. O antilaser poderá fazer isto.

Outra possibilidade é na radiologia, onde o princípio do laser reverso poderá ser usado para dirigir a radiação eletromagnética com precisão para um ponto específico no interior dos tecidos humanos, apesar da opacidade desses tecidos.

Fonte: Science